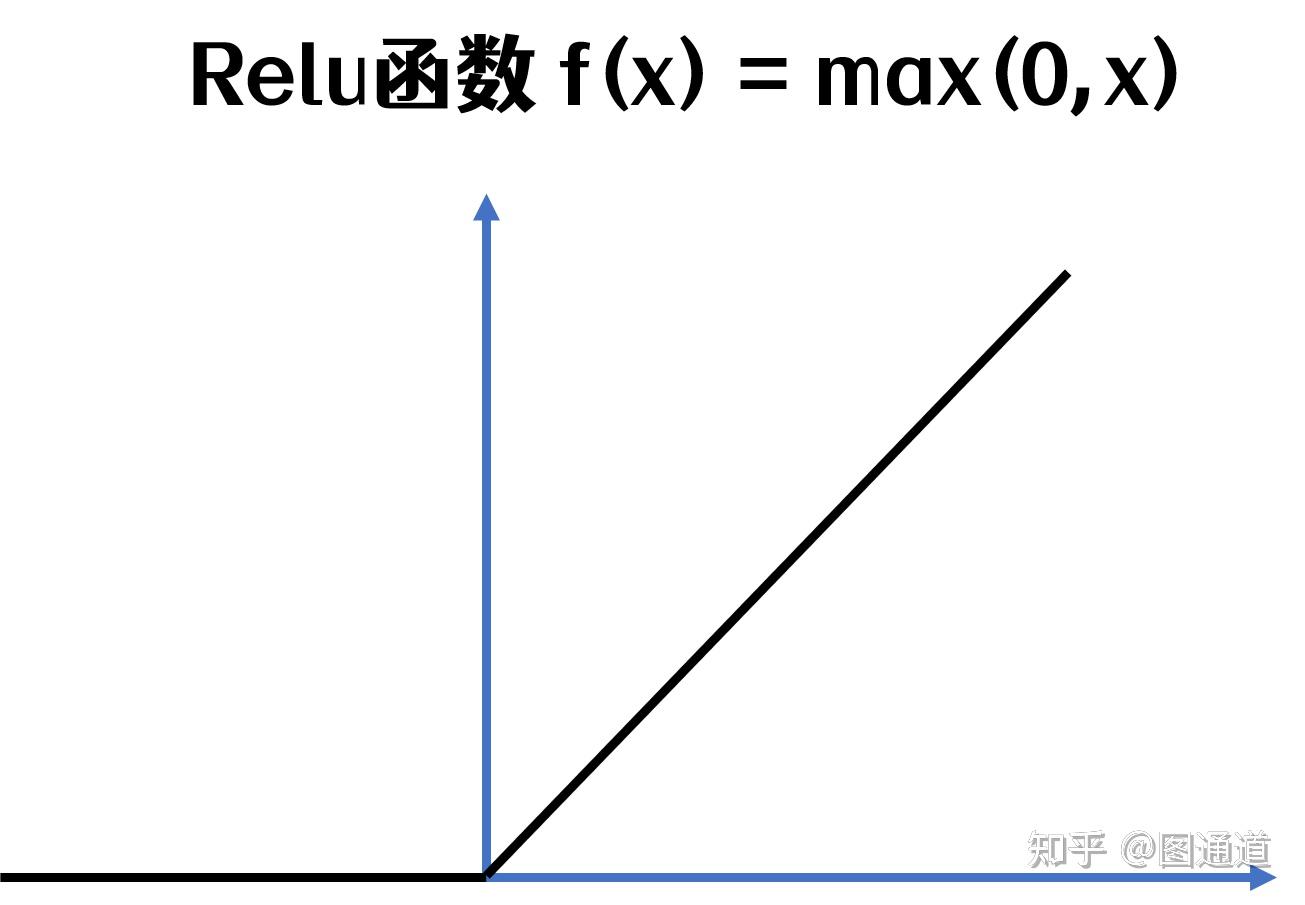

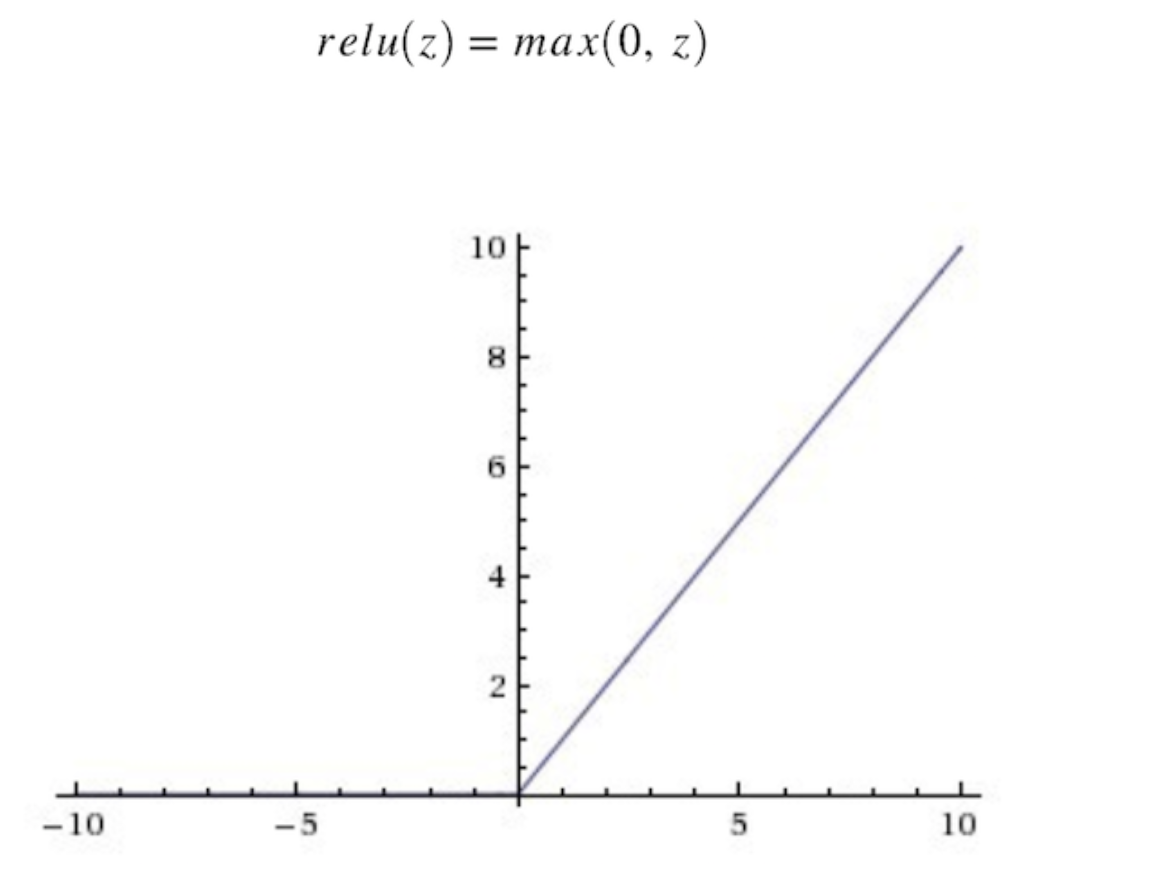

relu函数

![relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下](https://imgs.wantubizhi.com/img/A1A61BAA66193547F3A6DD7D8EE527E90E16B07FE3D90076DABC6437CAD9F5E89A7E005BAC2831CFE873ED4ED11B17E01072D70492A1230FFEE19BA87CE0DCC89E1128078448108128C217F23733CFE56E1483E98735F361943AE5DF7AE28FD2)

relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下

图片尺寸640x480

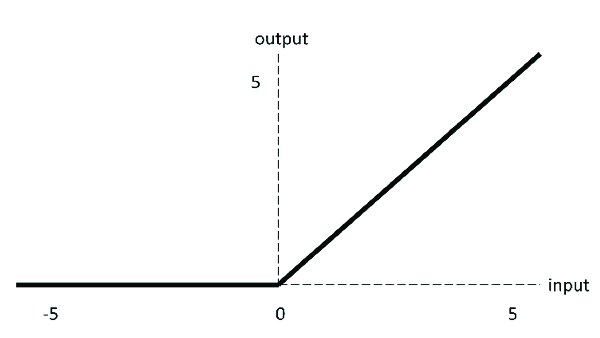

relu函数图像

图片尺寸527x388

激活层主要对卷积层的输出进行一个非线性映射,在cnn中一般为relu函数

图片尺寸1305x905

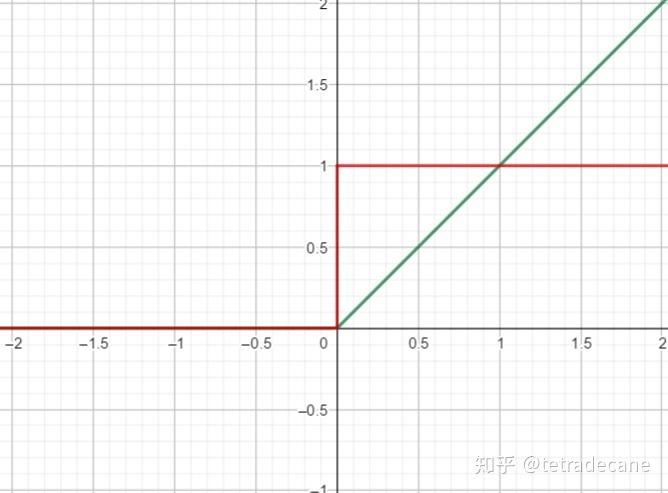

relu 激活函数:relu 导数:从上图可以看到,relu 是从底部开始半修正的

图片尺寸396x252

relu的函数图形

图片尺寸608x453

relu激励函数曲线fig curveofactivationfunctionrelu

图片尺寸1181x685

relu

图片尺寸600x338

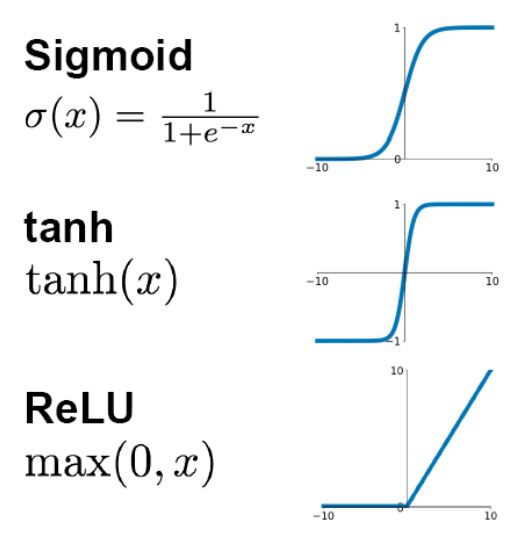

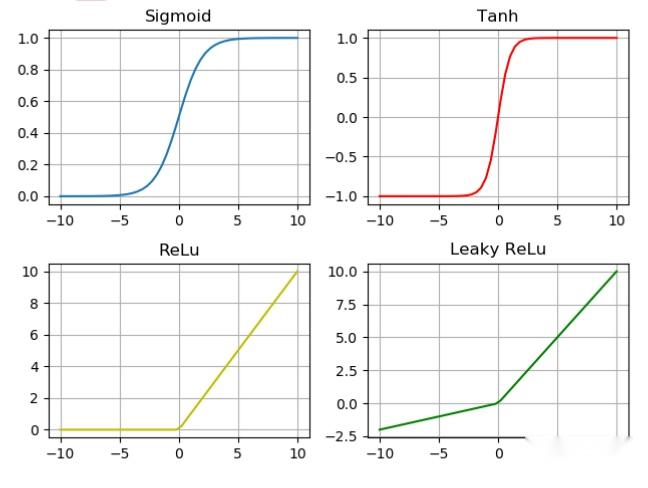

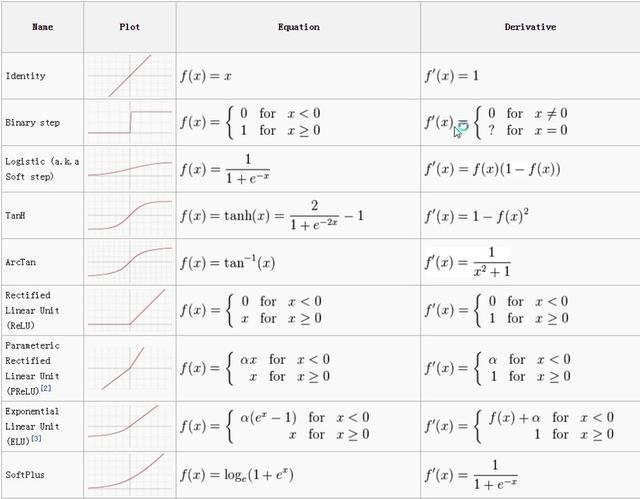

激活函数总结1relu及其变体

图片尺寸864x764

先看sigmoid,tanh和relu的函数图:解析:为什么relu要好过于tanh和

图片尺寸526x541

为什么要用relu激活函数,而不用sigmoid激活函数?

图片尺寸1139x971

relu激活函数

图片尺寸648x488

激活函数

图片尺寸1176x888

注意,该函数并非线性,其输出是非线性的. relu 的导数是

图片尺寸640x475

3.3 relu函数

图片尺寸668x493

激活函数总结1relu及其变体

图片尺寸1228x898

1. relu作为激活函数

图片尺寸584x225

以前神经网络中用的激活函数是sigmoid, 现在用的是relu

图片尺寸650x431

relu函数激活函数解析sigmoidtanhsoftmaxreluleakyrelu

图片尺寸640x499

激活函数总结1relu及其变体

图片尺寸916x796

3,relu函数,是目前最受欢迎的激活函数.

图片尺寸626x442

![relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下](https://imgs.wantubizhi.com/img/A1A61BAA66193547F3A6DD7D8EE527E90E16B07FE3D90076DABC6437CAD9F5E89A7E005BAC2831CFE873ED4ED11B17E01072D70492A1230FFEE19BA87CE0DCC89E1128078448108128C217F23733CFE56E1483E98735F361943AE5DF7AE28FD2)

![relu 的函数公式如下: [relu = max(0,x) ] relu 的函数图形如下](https://pics1.baidu.com/feed/03087bf40ad162d947a58504984ebceb8b13cdfc.jpeg?token=bbf567e4a6889a31377c7fecd8dc4130)